您现在的位置是:网站首页> AI人工智能

开源的的AI模型及调用平台

- AI人工智能

- 2024-10-11

- 690人已阅读

开源的的AI模型模型及调用平台

开源模型

简单几步微调Llama3变身中文大模型!PDF清洗外加Ollama和LM Studio本地加载微调好的大模型

调用框架

Windows下中文微调Llama3,单卡8G显存只需5分钟,模型可接入GPT4All、Ollama,实现CPU推理聊天,附Colab一键训练脚本

一键部署本地私人专属知识库,开源免费!可接入GPT-4、Llama 3、Gemma、Kimi等几十种大模型,零代码集成

Llama 3.1 一键本地部署!Meta 最强开源大模型,100%保证成功,无需GPU也能运行,可离线使用

5分钟做一个企业级AI问答系统,纯开源解决方案。老板乐开花 feat.FastGPT 上手体验

GPT4All语言大模型调用平台

Python语言使用

pip install gpt4all

from gpt4all import GPT4All

model = GPT4All("orca-mini-3b-gguf2-q4_0.gguf")

model = GPT4All(model_name='orca-mini-3b-gguf2-q4_0.gguf')

with model.chat_session():

reponse1 = model.generate(prompt='hello', temp=0)

response2 = model.generate(prompt='write me a short poem', temp=0)

response3 = model.generate(prompt='thank you', temp=0)

print(model.current_chat_session) === "Output"

json [ { 'role': 'user', 'content': 'hello' }, { 'role': 'assistant', 'content': 'What is your name?' }, { 'role': 'user', 'content': 'write me a short poem' }, { 'role': 'assistant', 'content': "I would love to help you with that! Here's a short poem I came up with:\nBeneath the autumn leaves,\nThe wind whispers through the trees.\nA gentle breeze, so at ease,\nAs if it were born to play.\nAnd as the sun sets in the sky,\nThe world around us grows still." }, { 'role': 'user', 'content': 'thank you' }, { 'role': 'assistant', 'content': "You're welcome! I hope this poem was helpful or inspiring for you. Let me know if there is anything else I can assist you with." } ]

在上下文中使用 GPT4All 模型时chat_session():

连续的聊天交流会被考虑在内,并且在会话结束之前不会被丢弃;只要模型有能力。

系统提示符被插入到模型上下文的开头。

传递到的每个提示都generate()包含在适当的提示模板中。如果您传递allow_download=False 给 GPT4All 或使用的模型不是来自官方模型列表,则必须使用 prompt_template参数传递提示模板chat_session()。

注意:如果您不使用chat_session(),则对 的调用generate()将不会包含在提示模板中。这将导致模型继续提示而不是回答它。如有疑问,请使用聊天会话,因为许多较新的模型被设计为专门与提示模板一起使用。

指定模型文件夹

模型文件夹可以model_path在创建GPT4All实例时通过参数设置。下面的示例与未提供时相同;也就是说,~/.cache/gpt4all/是默认文件夹。

from pathlib import Path

from gpt4all import GPT4All

model = GPT4All(model_name='orca-mini-3b-gguf2-q4_0.gguf', model_path=Path.home() / '.cache' / 'gpt4all')

不允许在线下载模型

from gpt4all import GPT4All

model = GPT4All('orca-mini-3b-gguf2-q4_0.gguf', allow_download=False)

system_prompt = '### System:\nYou are an AI assistant that follows instruction extremely well. Help as much as you can.\n\n'

prompt_template = '### User:\n{0}\n\n### Response:\n'

with model.chat_session(system_prompt=system_prompt, prompt_template=prompt_template):

import json

import gpt4all

gptj = gpt4all.GPT4All("ggml-gpt4all-j-v1.3-groovy")

messages = [{"role": "user", "content": "Can you explain what is a large language model?"}]

ret = gptj.chat_completion(messages)

messages.append(ret["choices"][0]["message"])

messages.append({"role": "user", "content": "Can you give some examples applications?"})

ret = gptj.chat_completion(messages)

messages.append(ret["choices"][0]["message"])

messages.append({"role": "user", "content": "Are there any limitations?"})

ret = gptj.chat_completion(messages)

消息。append(ret[“choices”][0][“message”])

消息。append({“role”: “user”, “content”: “用两句话总结上述内容。})

RET = GPTJ。chat_completion(消息)

打印(JSON.转储(消息,缩进 = 4))

打印(JSON.转储(ret, 缩进=4))

您多次调用了该模型。每次它响应时,您都会获取输出并将其附加到消息列表中,以便累积上下文。然后,添加新对话框并再次调用该模型。您需要收集消息,因为每次调用模型时,它都会在不知道上一个对话的情况下重新开始。因此,您的工作是保留历史记录以提醒模型其先前的反应。

LM Studio模型调用平台

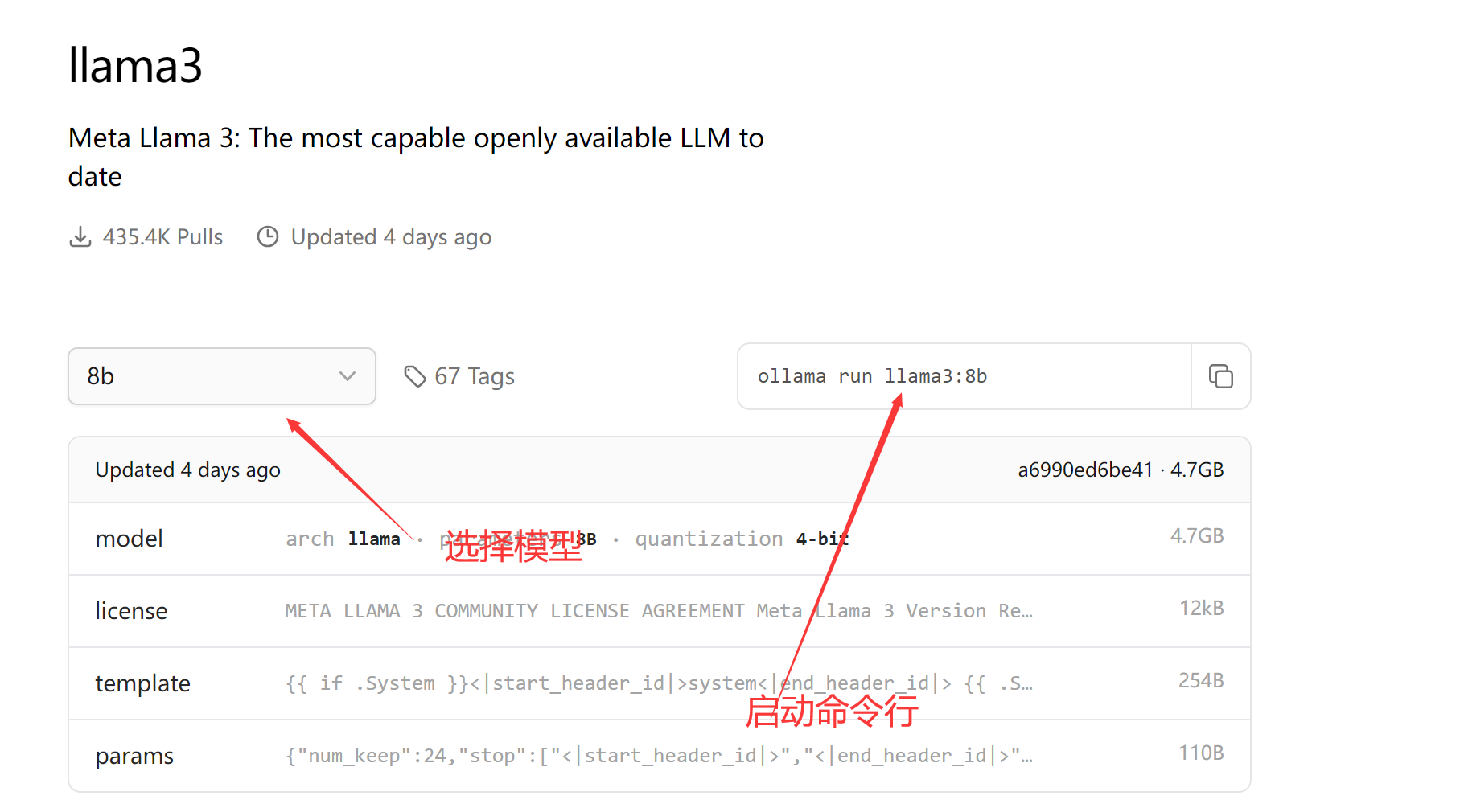

Ollama 模型调用平台

软件主页点击Models进入可以看到支持的model

点击一个如llama3,可以查看命令函启动方式

启动:ollama run llama3:8b

API调用

Example using curl:

curl -X POST http://localhost:11434/api/generate -d '{

"model": "llama3",

"prompt":"Why is the sky blue?"

}'

model也下面有查看API文档链接

web或桌面客户端调用ollama服务

- Open WebUI

- Enchanted (macOS native)

- Lollms-Webui

- LibreChat

- Bionic GPT

- HTML UI

- Saddle

- Chatbot UI

- Chatbot UI v2

- Typescript UI

- Minimalistic React UI for Ollama Models

- Ollamac

- big-AGI

- Cheshire Cat assistant framework

- Amica

- chatd

- Ollama-SwiftUI

- Dify.AI

- MindMac

- NextJS Web Interface for Ollama

- Msty

- Chatbox

- WinForm Ollama Copilot

- NextChat with Get Started Doc

- Alpaca WebUI

- OllamaGUI

- OpenAOE

- Odin Runes

- LLM-X: Progressive Web App

- AnythingLLM (Docker + MacOs/Windows/Linux native app)

- Ollama Basic Chat: Uses HyperDiv Reactive UI

- Ollama-chats RPG

- QA-Pilot: Chat with Code Repository

- ChatOllama: Open Source Chatbot based on Ollama with Knowledge Bases

- CRAG Ollama Chat: Simple Web Search with Corrective RAG

- RAGFlow: Open-source Retrieval-Augmented Generation engine based on deep document understanding

- chat: chat web app for teams

- Lobe Chat with Integrating Doc

- Ollama RAG Chatbot: Local Chat with multiples PDFs using Ollama and RAG.

AnythingLLM搭建本地知识库

Windows下中文微调Llama3,单卡8G显存只需5分钟,模型可接入GPT4All、Ollama,实现CPU推理聊天,附Colab一键训练脚本

一键部署本地私人专属知识库,开源免费!可接入GPT-4、Llama 3、Gemma、Kimi等几十种大模型,零代码集成

MaxKB项目地址

https://github.com/1Panel-dev/MaxKB

Docker桌面程序下载

https://www.docker.com/products/docker-desktop/

MaxKB docker 部署指令

docker run -d --name=maxkb -p 8080:8080 -v ~/.maxkb:/var/lib/postgresql/data 1panel/maxkb

MaxKB本地登录

用户名: admin

密码: MaxKB@123..

Ollama下载

Llama文本开源模型

Meta 官方 Llama 3.1 介绍文章:

https://ai.meta.com/blog/meta-llama-3-1/

Hugging Face Llama 3.1 介绍文章:

https://huggingface.co/blog/llama31

Llama 3.1 Model Card:

https://github.com/meta-llama/llama-models/blob/main/models/llama3_1/MODEL_CARD.md

HuggingChat 聊天页面:

Groq:

LM Studio 官网:

Llama 3.1 一键本地部署!Meta 最强开源大模型,100%保证成功,无需GPU也能运行,可离线使用

1.本地电脑安装的硬件要求:

Windows:3060以上显卡+8G以上显存+16G内存,硬盘空间至少20G

Mac:M1或M2芯片 16G内存,20G以上硬盘空间

在开始之前,首先我们需要安装Ollama客户端,来进行本地部署Llama3.1大模型

官方下载:【点击前往】

安装命令:

安装llama3.1-8b,至少需要8G的显存,安装命令就是

ollama run llama3.1:8b

安装llama3.1-70b,至少需要大约 70-75 GB 显存,适合企业用户,安装命令就是

ollama run llama3.1:78b

安装llama3.1-405b,这是一个极其庞大的模型,安装和运行它在本地需要非常高的显存和硬件资源,至少需要大约 400-450 GB 显存,适合顶级大企业用户,安装命令就是

ollama run llama3.1:405b

简单几步微调Llama3变身中文大模型!PDF清洗外加Ollama和LM Studio本地加载微调好的大模型

5分钟做一个企业级AI问答系统,纯开源解决方案。老板乐开花 feat.FastGPT 上手体验